Resumo: : A segregação e a usurpação de dignidade humana interpenetrados no cotidiano das pessoas negras, embora sejam estruturalmente institucionalizadas, sobretudo no estrato social brasileiro, atualizam as suas formas de aplicação conforme as tecnologias mudam. Atualmente, a ampliação de sistemas de monitoramento facial nos setores público e privado em todo o mundo tem fomentado o aprofundamento dessas desigualdades, revelando que, na verdade, a positivação dos direitos humanos pode, muitas vezes, ser apresentada como um conto normativo que precisa ser trazido à concretude.

Palavras-chave: direitos humanos; racismo estrutural; monitoramento facial; tecnologia; desigualdade.

Resumo: : A segregação e a usurpação de dignidade humana interpenetrados no cotidiano das pessoas negras, embora sejam estruturalmente institucionalizadas, sobretudo no estrato social brasileiro, atualizam as suas formas de aplicação conforme as tecnologias mudam. Atualmente, a ampliação de sistemas de monitoramento facial nos setores público e privado em todo o mundo tem fomentado o aprofundamento dessas desigualdades, revelando que, na verdade, a positivação dos direitos humanos pode, muitas vezes, ser apresentada como um conto normativo que precisa ser trazido à concretude.

Palavras-chave: direitos humanos; racismo estrutural; monitoramento facial; tecnologia; desigualdade.

INTRODUÇÃO

Em um mundo marcado pela globalização, desenvolve-se, cada vez mais, métodos e técnicas que possam automatizar processos e agilizar trabalhos. Em uma corrida por tempo e sede de tecnologia, o ser humano retém uma necessidade de introduzir técnicas avançadas que consigam processar e armazenar informações, assim como mecanizar atividades.

Nesse contexto, destaca-se a diferença entre o mundo moderno e o mundo pré-industrial. Na atualidade, vive-se a crescente substituição do homem pela máquina em diversos setores da economia, ocasionando, por sua vez, o aparecimento de novas formas de procedimentos e produções industriais.

Contudo, faz-se necessário observar de forma mais cautelosa esses novos métodos para compreender como os mesmos impactam e funcionam no cotidiano das pessoas. Sob essa ótica, muitas dessas técnicas acabam por fomentar discriminações já enraizadas na sociedade, incentivando e atualizando os meios de repressão. Desta forma, grupos vulneráveis e marginalizados se tornam os maiores alvos, aumentando, ainda, a discrepância social existente.

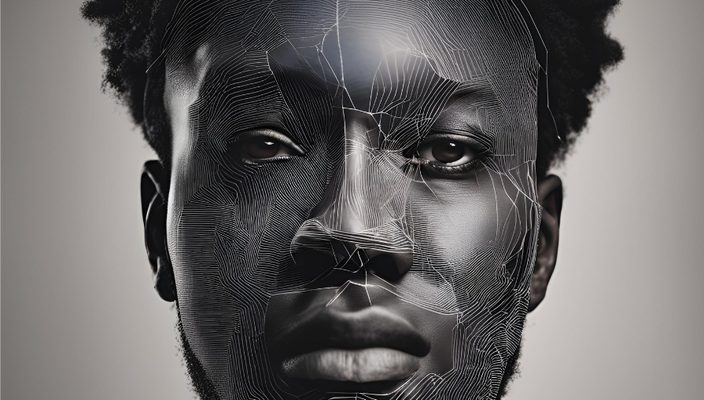

Nesse sentido, pode-se citar como exemplificação desses novos procedimentos o monitoramento facial. Essa tecnologia estimula a violação dos direitos humanos na vida da população negra e encoraja o encarceramento em massa desses. Sendo assim, torna-se essencial a realização de fiscalizações e regulamentações mais eficazes que busquem dar fim a essa problemática e concretizar, de fato, as garantias previstas na constituição.

Para a abordagem mais profunda deste tema, em um primeiro plano, será explicado o conceito de monitoramento facial. Em seguida, será apresentado como são armazenados e utilizados os dados coletados nos espaços públicos. Após isso, será mostrado como a tecnologia de reconhecimento facial se tornou uma ameaça para a população negra e, posteriormente, quais são os direitos humanos violados nos usos e nas falhas dessa tecnologia. Por fim, buscando uma ilustração no plano real, expõem-se casos concretos demonstrando como essa problemática está presente no cotidiano da sociedade.

1. O CONCEITO DE MONITORAMENTO FACIAL

O conceito de monitoramento facial foi desenvolvido por Woodrow Wilson Bledsoe, em 1964, ao realizar experimentos para verificar se os computadores de programação poderiam reconhecer rostos humanos. O matemático e cientista da computação estadunidense Bledsoe, líder dessa pesquisa, criou um sistema híbrido no qual o mapeamento das características era feito manualmente e os dados colocados em um computador fariam o reconhecimento. Contudo, na atual conjuntura, cidades e países inteiros proíbem a utilização de reconhecimento facial devido aos riscos do uso falho e imprudente. Enquanto isso, no Brasil, a tecnologia ganha cada vez mais adeptos em aplicativos pessoais de foto, na autenticação secundária para dispositivos móveis, na cobertura de eventos para confirmação dos convidados e até mesmo no resgate de vítimas de tráfico de pessoas, já que se tornou mais acessível nas últimas décadas. No país, há iniciativas em Ilhéus (Bahia), desde 2011, e em Jaboatão (Pernambuco), desde 2016, para que o sistema de monitoramento seja testado em escolas municipais com o objetivo de controlar a evasão escolar. A partir de meados de 2018, esse sistema se tornou mais ativo quando, das 37 iniciativas desse processo que as cidades adotaram, 19 foram utilizadas nas áreas de segurança pública, transporte e controle de fronteiras.

O reconhecimento facial consiste em um procedimento de biometria que busca identificar uma pessoa pela análise de traços faciais por meio de um filtro que verifica se a face no sistema corresponde ou não à face de um determinado indivíduo, possibilitando a automatização desses feitos. Desse modo, o sistema detecta e coleta as características do rosto, o que gera uma identidade facial que é transformada em código numérico no qual as pessoas são classificadas por padrões. Após o rastreamento e análise, é necessário fazer uma comparação das informações obtidas com uma base de dados, na qual, diante das características, se comprova a veracidade da identidade informada. Por exemplo, em um serviço que necessite de autenticação, a câmera filma ou registra uma imagem e o sistema busca nesse banco se há alguma face com determinado nível de semelhança, comparando-as.

Dentro desse parâmetro, os recursos de análise facial, como, por exemplo, os disponibilizados na ferramenta do Amazon Rekognition1, alegam ser usados apenas para restringir o campo de possíveis correspondências, com o intuito de gerar resultados que ajudem os agentes a obterem rapidamente um grupo de possíveis rostos que, depois, passam por uma análise humana mais aprofundada. Assim, essa técnica cria mecanismos que analisam os atributos para detecção facial como, por exemplo, a geometria visual, o humor, a cor de cabelo e os olhos abertos ou fechados. Dentro dessa ótica, por ser uma ferramenta probabilística, esse sistema consegue prever, por meio de uma pontuação de similaridade, a probabilidade de que dois rostos em uma imagem pertençam a uma mesma pessoa. Esse grau de semelhança precisa ser devidamente calibrado, uma vez que, se for fixado em níveis menores do que 90% de semelhança, ele pode vir a provocar um número muito grande de falsos positivos. Contudo, apesar de uma pontuação maior significar uma maior probabilidade, uma similaridade de 99% de possibilidade pode não garantir a geração de uma combinação realmente positiva.

Nesse cenário, a tecnologia pode ajudar os dispositivos a se tornarem mais independentes e a enviarem notificações quando virem um desconhecido em um banco de dados, por exemplo, além de impedir prejuízo financeiro e garantir a credibilidade no contexto do seu uso em empresas. É notório que a maioria dos eletrônicos novos já tem essa ferramenta, todavia, nem todos os casos são seguros, como exemplo, quando uma pessoa é detida por engano após ter sido erroneamente reconhecida pelas câmeras. Além disso, vale destacar que, para dificultar ainda mais tal detecção, manifestantes e outras pessoas que queiram escapar do monitoramento ao redor do mundo têm lançado mão da utilização de camuflagens que escondam seus rostos como pinturas faciais. Nesse contexto, com o intuito de contornar essa problemática, está em pauta, hoje, a possível análise da textura de pele, priorizando o intervalo entre poros, técnica que pretende superar as dificuldades anteriores.

No período da pandemia do Covid-19, o monitoramento facial dependia substancialmente da identificação da área ao redor dos olhos, uma vez que o uso de máscaras faciais de proteção anti-viral é observado ao redor do mundo, o que representa um desafio ainda maior, já que o software de monitoramento e reconhecimento é menos preciso e eficaz na hora de fazer a correspondência entre rostos mascarados e rostos sem máscaras. Apesar de pssuir benefícios, essa ferramenta tem sofrido diversas críticas pelos defensores da privacidade e da dignidade, uma vez que essa tecnologia está muito mergulhada em preconceitos raciais e potenciais uso indevidos, além agravar o encarceramento em massa, principalmente de jovens negros e das periferias brasileiras, tópicos que serão profundamente abordados em breve nesse artigo.

2. O ARMAZENAMENTO E A UTILIZAÇÃO DOS DADOS COLETADOS NOS ESPAÇOS PÚBLICOS

A utilização da tecnologia de reconhecimento - ainda em desenvolvimento - está, como bem mencionado anteriormente, cada vez mais recorrente na sociedade, mas, ao mesmo tempo em que pode trazer benefícios e ser útil para a segurança pública, essa nova tecnologia pode apresentar índices de falibilidade perigosos como a identificação errônea de inocentes em processos criminais, acarretando em um processo traumático em suas vidas2. Nesse sentido, o direito deve apresentar respostas considerando a seletividade de um sistema penal brasileiro e racista, uma vez que utiliza uma tecnologia na qual, em seu próprio algoritmo, se encarrega de apontar pessoas, equivocadamente, como potenciais suspeitas de um crime, o que, inegavelmente, propicia que indivíduos negros estejam “sujeitos à automatização de constrangimentos e violências, como abordagens policiais indevidas e atribuição inverídica de antecedentes criminais” (RODRIGUES, Gustavo). Segundo o professor da Faculdade de Direito da Universidade de São Paulo (USP), existem riscos associados a essa tecnologia:

Tecnologia que objetiva o reconhecimento com margens de erros arbitrárias e a depender de como a régua é modificada, as consequências são graves. O reconhecimento facial é tão perigoso quando mal usado que não vale o risco disso ser popularizado. Seria a tecnologia dos sonhos de governos autoritários3.

Nesse sentido, existe uma certa preocupação com relação aos impactos discriminatórios do monitoramento facial, o que é, também, confirmado por diferentes estudos que já demonstraram a falibilidade desse sistema em apontar, de forma menos precisa, a identificação de pessoas de determinados grupos demográficos, principalmente mulheres e pessoas negras4. Os pesquisadores do Instituto Nacional de Padrões e Tecnologia (NIST na sigla em inglês) publicaram um estudo em 2019, no qual descobriram que as taxas de falsos positivos para pessoas negras e asiáticas eram até 100 vezes maiores do que para pessoas caucasianas. Portanto, esta constatação reforça as chances dessa nova tecnologia apresentar resultados imprecisos e enviesados, o qual pode acarretar constrangimentos e aprofundamento de preconceitos estruturais que já existem na nossa sociedade.

Paralelo a isso, pode-se citar que, recentemente, em decisão histórica5, o Tribunal de Recurso concluiu que a Polícia de Gales (South Wales Police) violou os direitos humanos ao usar ilegalmente o monitoramento facial em algumas ocasiões na cidade de Cardiff6. De acordo com o entendimento da Corte, a utilização dessa tecnologia pela força policial não respeitou o direito à privacidade do artigo 8º da Convenção Europeia de Direito Humanos (CEDH), visto que não havia base legal clara e suficiente que explicasse em que momento o sistema poderia ser utilizado e quem poderia ser identificado e estar no banco de dados policial de suspeitos.

Nesse contexto, a nova Lei Geral de Proteção de Dados Pessoais (LGPD),7 no Brasil, chega como uma evolução necessária, prevendo uma série de restrições ao uso, ao tratamento, ao armazenamento e à coleta de dados pessoais8 que visa garantir e proteger os direitos e liberdades fundamentais, em particular, o direito à proteção de dados pessoais, assegurando o respeito à privacidade e à propriedade de cada indivíduo de suas próprias informações. A respeito disso, José Afonso da Silva (SILVA, 2000, p. 209-210) afirma que:

O intenso desenvolvimento de complexa rede de fichários eletrônicos, especialmente sobre dados pessoais, constitui poderosa ameaça à privacidade das pessoas. O amplo sistema de informações computadorizadas gera um processo de esquadrinhamento das pessoas, que ficam com sua individualidade inteiramente devassada. O perigo é tão maior quanto mais a utilização da informática facilita a interconexão de fichários com a possibilidade de formar grandes bancos de dados que desvendam a vida dos indivíduos, sem sua autorização e até sem seu conhecimento.

Diante do exposto, pode-se ressaltar que, enquanto as câmeras estão captando as imagens de espaços públicos para o reconhecimento facial, esse sistema, também, está alimentando um novo banco de dados com rostos que ainda não faziam parte dessa coleta. Desse modo, não são apenas dados de criminosos que são coletados, mas, também, de transeuntes comuns também.

O diretor executivo do Instituto de Tecnologia e Sociedade do Rio de Janeiro, destaca que

o reconhecimento facial é invasivo, porque você monitora a pessoa pelo rosto dela. E se eu não cometi nenhum nenhum crime, tenho o direito de não ser rastreado, pois com essa gravação, é possível ter a inserção na vida privada de cada um, o que pode ser danoso 9.

De acordo com o Professor do Data Privacy, Bruno Bioni, apesar do Brasil ter aprovado uma lei de proteção de dados pessoais, existe a exclusão da aplicação dela em casos de informações para fins de segurança pública. Do mesmo modo, é necessário requerer uma maior proteção dos dados e controle de quem fica responsável por tomar conta deles. Por isso, é preciso ter atenção e questionar o destino e o armazenamento desses dados sensíveis, pois se forem compartilhados para outros fins podem colocar a população em risco.

Nesse contexto, Bruce Schneier (SCHNEIER, 2006) aponta que:

O “maremoto” de dados pessoais gerados nas relações do cotidiano representa a poluição da era da informação: assim como a produção industrial gera resíduos, computadores utilizados para processar informações produzem dados; se ignorados, esses dados permanecerão registrados para sempre, sendo necessário regular sua geração, seu uso e seu descarte.

Contudo, ao contrário do que é sugerido por algumas organizações, o banimento desse novo sistema não é o caminho e nem a solução mais adequada, já que a tecnologia, por si só, não é o verdadeiro problema, mas sim a forma de como os dados são coletados e utilizados. Compete aos cidadãos, às empresas e à política pública encarar essa ferramenta como algo que possa trazer benefícios à sociedade, mas que, ainda, necessita de mudanças, de um maior debate público e de regulamentações que visam uma maior proteção e transparência diante das questões abordadas neste tópico.

3. O DESAFIO DO RECONHECIMENTO FACIAL NO QUE TANGE À POPULAÇÃO NEGRA

A partir da apresentação do que é monitoramento facial, bem como as suas implicações dentro do setor público, faz-se, ainda, mais urgente delimitar qual o grupo em posição de maior vulnerabilidade e entender como esses mecanismos reforçam um status quo estabelecido a partir das premissas do racismo presente no corpo social. As bases fundantes da discussão aqui presente estão muito relacionadas à interligação do conceito de racismo estrutural ao entendimento da teoria crítica dos direitos humanos. De início, é necessário entender o que é raça e o que é racismo. Raça pode ser entendido como um conceito político empregado no mundo dos fatos como um elemento que fundamenta a exploração, a depredação e, até mesmo, o extermínio de minorias. A partir disso, o racismo pode ser compreendido, a partir da visão de Silvio Almeida (ALMEIDA, 2018, p. 25), como:

[...] uma forma sistemática de discriminação que tem a raça como fundamento, e que se manifesta por meio de práticas conscientes ou inconscientes que culminam em desvantagens ou privilégios para indivíduos, a depender do grupo racial ao qual pertençam.

Desse modo, é possível identificar o racismo como um fenômeno interpenetrado sistematicamente nas relações construídas no mundo fático. Contudo, é relevante frisar que ele não se resume apenas a uma conduta de cunho discriminatório, pelo contrário, o racismo tem a ver com um encadeamento de condutas que constroem, pouco a pouco, uma conjuntura que atribui status de inferioridade a certos grupos e status de privilégio a outros. O racismo estrutural, de certo modo, amplia a concepção institucional que, por sua vez, diz respeito a como as instituições presentes no extrato social conseguem controlar, dominar e manter o seu poder a partir da imposição de parâmetros discriminatórios que têm por objetivo manter a hegemonia do grupo racial mais poderoso (ALMEIDA, 2018, p. 31). Assim, o racismo estrutural, estendendo essa discussão, tenta mostrar que o racismo não é uma simples criação das instituições, de outro modo, ele é um produto de suas práticas. Dessa maneira, ele não deve ser encarado como uma anomalia sócio-institucional, pelo contrário, ele deve ser visto como uma consequência consuetudinária da estrutura social.

Indo além, a leitura crítica dos direitos humanos tenta afastar o humanismo abstrato presente na teoria clássica que, por sua vez, acredita que os direitos humanos são pontos de chegada (BATISTA, LOPES, 2014, p. 3), ou seja, acredita que a regulamentação dos direitos humanos reconhecida pelo ordenamento jurídico seria o bastante para que a dignidade da pessoa humana pudesse ser preservada. A teoria crítica, então, reivindica espaço em um cenário no qual se faz urgente conectar o arcabouço teórico-jurídico à experimentação desses direitos na concretude. Ela, ao contrário da teoria clássica - partindo do contexto social a não do jurídico em abstrato - vê os direitos humanos como ponto de partida para a visibilização das desigualdades. Dessarte, é possível inferir que ler o racismo estrutural a partir das lentes da teoria crítica dos direitos humanos é entender que, mesmo tendo direitos abstratos positivados em constituições e em tratados internacionais, a condição factual do racismo estrutural, diversas vezes, coloca em cheque, cotidianamente, a dignidade das pessoas negras, e as implicações do monitoramento facial à população negra precisam ganhar relevância nos debates atuais - e é isso que o presente trabalho tentará construir.

A inteligência artificial tem intensificado, ainda mais, o racismo desde a concepção dos algoritmos e dos códigos de criação de tecnologias. Nesse sentido, uma pesquisadora do MIT Media Lab, Joy Buolamwini10, concluiu que os mecanismos de reconhecimento facial têm dificuldades de reconhecer os rostos de pessoas negras, sobretudo, porque os algoritmos são montados por engenheiros e cientistas que não utilizam uma base de dados diversificada. Isto é, no processo de construção dos softwares, esses profissionais têm codificado características que são especificamente melhor identificáveis em pessoas brancas, isso porque os códigos envolvidos nessa programação tem como base testes feitos majoritariamente em rostos caucasianos. Ademais, esse estudo também concluiu que existia uma taxa de erro de identificação de 34% nas mulheres negras, 49 vezes maior do que nos homens brancos. Buolamwini acredita que uma força que ela chama de olhar codificado ou viés algorítmico, bem como o preconceito humano, resulta em desigualdades raciais, contudo, o ponto crítico é que, diferentemente das informações repassadas estritamente por pessoas em seus diálogos e relatórios não computadorizados, o viés algorítmico é capaz de se espalhar exponencial e rapidamente.

Os programas de reconhecimento facial são arquitetados com as técnicas de machine-learning na qual funciona uma sequência de treinamentos com alguns rostos. Entretanto, se o processo de ensinar o software a reconhecer os rostos não possui um material racialmente diversificado, torna-se muito mais custoso identificar pessoas negras. Prova disso é que um estudo do National Institute of Standards (NIST)11 concluiu que os softwares de reconhecimento facial conseguem reconhecer mais precisamente pessoas asiáticas quando são codificados por países asiáticos, ao contrário dos codificados em países não asiáticos, uma vez que eles trabalham com um material próprio. Além disso, descobriu-se que houve um maior número de falsos positivos no reconhecimento de rostos asiáticos e afro-americanos em comparação aos rostos caucasianos.

No que diz respeito à extensão dessa problemática às instituições, múltiplos departamentos policiais lançam mão da tecnologia de reconhecimento facial para identificar possíveis suspeitos em crimes e, assim, conseguir prendê-los. Esse procedimento, se enxergado pelas lentes do que é racismo estrutural, está totalmente correlacionado à discriminação e violência policial direcionadas às pessoas negras, uma vez que cotidianadamente, mesmo sem o uso de softwares de monitoramento, as pessoas pretas são as maiores vítimas da depredação estatal e, por consequência, são as mais encarceradas injustamente. Nesse sentido, os erros no reconhecimento facial desse grupo minoritário derivados, sobretudo, da sub-representação desses grupos na base de dados dos softwares de reconhecimento facial aprofundam ainda mais as desigualdades fáticas e escancaram uma nova maneira de fomentar as injustiças advindas do racismo.

Além disso, as implicações negativas do reconhecimento facial também alcançaram o solo brasileiro: uma pesquisa levantada pela Rede de Observatórios da Segurança aponta que 90,5% das pessoas que foram detidas em razão dessa tecnologia são negras.12 O sistema policial utiliza o software de reconhecimento para conseguir mapear o rosto dos indivíduos em comparação aos rostos de pessoas que estão sendo investigadas presentes no banco de dados da polícia. Dentro dessa conjuntura, como bem aponta Simone Browne, racializar a vigilância dentro de sistemas computadorizados produz efeitos dentro e fora da digitalidade, e os dados extraídos dos indivíduos têm marcações sensíveis a respeito de sua raça que podem lesá-los.

Fica claro, portanto, que as formas de repressão e violência às pessoas negras se atualizam junto às tecnologias de maneira orgânica dentro da sociedade e tem como consequência e objetivo principal a segregação e o encarceramento em massa desse grupo. Por esse motivo, deve-se olhar para as atualizações das formas de repressão para que elas sejam destacadas e analisadas, sobretudo, a partir de um olhar sócio normativo. Urge, hoje, a necessidade de se pensar na inclusão de pessoas negras em todos os espaços sociais, sobretudo, na academia e na produção científica, uma vez que essa sub-representação, seja como profissional, seja como objeto de estudo, é um dos principais fatores que provocam a identificação falha de pessoas negras por meio dos programas de reconhecimento facial. Desse modo, diante do encadeamento de problemáticas estruturais dentro de uma conjuntura social racista, a teoria crítica faz um convite para que se olhe para a concretude e se verifique se ela corresponde à positivação de direitos humanos nas suas mais diversas formas, tanto no Brasil, quanto no mundo.