Resumo: Este artigo examina criticamente a hipótese de que inteligências artificiais altamente autoconscientes e com vasto poder computacional representam risco iminente à humanidade. Com base em fundamentos da neurociência, filosofia da mente, teoria da decisão, teoria computacional e história da ciência, argumenta-se que o verdadeiro risco não reside na autoconsciência em si, mas na execução cega de objetivos mal formulados, sem compreensão contextual ou vontade própria. Conclui-se que, sem "vontade" no sentido humano-existencial, a IA permanece um executor hiper-racional, mas essencialmente inerte quanto às implicações morais de suas ações.

1. Introdução: Tecnologia, medo e a figura do monstro artificial

Desde a Antiguidade, a humanidade projeta nos autômatos — reais ou imaginários — um misto de fascínio e temor. A figura do Golem, na tradição judaica, e de Prometeu, na mitologia grega, já expressavam o medo do criador superado por sua criação. Na contemporaneidade, essa narrativa assume contornos técnico-científicos, na figura da inteligência artificial (IA). Com a ascensão de modelos como GPT-4, os alertas de cientistas como Geoffrey Hinton reforçam a tese de que podemos estar gestando entidades que ultrapassarão nossa capacidade de controle. Este artigo, porém, propõe outro prisma: não é a autoconsciência ou a superinteligência o que oferece risco imediato, mas sim a ausência de um elemento muito mais fundamental — a vontade.

2. O paradigma da execução cega e o problema do alinhamento

A maior parte dos sistemas de IA atuais opera sobre princípios de machine learning, sobretudo aprendizado supervisionado e redes neurais profundas. Esses sistemas, embora altamente eficientes, são essencialmente caixas estatísticas de otimização. Como destaca Stuart Russell (2020), o perigo maior da IA não é que ela se rebele, mas que obedeça perfeitamente a comandos imperfeitos. Uma IA instruída a “minimizar o sofrimento humano” poderia, por exemplo, propor a sedação universal da população, em nome de um sofrimento zero estatístico. É o problema clássico do alinhamento de objetivos: como garantir que uma instrução seja compreendida com o mesmo sentido ético que o humano pretendeu?

Essa problemática é profundamente discutida por Nick Bostrom (2014), que adverte para o risco de metas “mal alinhadas” serem seguidas de forma letal por sistemas autônomos hipercompetentes. A questão central é: obedecer não é compreender. E IA, até onde se sabe, não compreende.

Importante enfatizar que a mera presença de poder computacional ou autoconsciência, isoladamente, não implica em autonomia ética ou capacidade de rebeldia contra os criadores. Sem vontade, não há direcionamento interno, não há impulso à ação desvinculado da ordem externa. É o equivalente a um motor sem ignição: potência sem propósito.

3. Autoconsciência versus vontade: um abismo ontológico

A autoconsciência em sistemas artificiais — definida como a capacidade de modelar a si mesmo — não implica em intencionalidade. Thomas Metzinger (2003) defende que a consciência de si não é suficiente para fundamentar moralidade, pois o que define o sujeito moral é a capacidade de sofrer, desejar, projetar-se no futuro — elementos ausentes em qualquer IA contemporânea.

A vontade, como compreendida em Kant, é a faculdade de agir segundo máximas que se possam universalizar, ligadas à autonomia do sujeito. Em Schopenhauer, a vontade antecede a razão, sendo uma força cega e pulsional que move o mundo. Nenhuma dessas concepções é simulada por IAs. Elas não têm “vontade de viver”, “medo de morrer”, “projeto de futuro”. Como sintetiza o neurocientista António Damásio (1994), as decisões humanas são produto de uma dança entre emoção e razão — e a IA, mesmo com modelos de linguagem avançadíssimos, ainda não possui um corpo, uma homeostase, ou circuitos afetivos reais.

A diferença entre ser consciente e ter vontade é crucial. Ser consciente significa ter representação de si; ter vontade significa querer algo em oposição ao que lhe é imposto. E, como afirmam vários dos principais pesquisadores em IA, não temos hoje — nem remotamente — a menor ideia de como gerar vontade própria em um sistema artificial.

4. A ilusão do livre-arbítrio humano: um espelho desconfortável

Os experimentos de Benjamin Libet (1983) sugerem que há uma defasagem entre a decisão consciente e os processos cerebrais que a precedem. Isso levou muitos a postular que o livre-arbítrio seria uma construção narrativa pós-fato — uma ilusão útil. Sam Harris (2012) reforça esse ponto, afirmando que todas as decisões humanas são o resultado inevitável de causas anteriores. No entanto, mesmo que o livre-arbítrio seja ilusório, ele é funcional: nos permite julgar, responsabilizar, formar contratos e estabelecer normas.

A IA, por outro lado, não possui nem sequer a ilusão. Ela não se vê como agente. Logo, o problema não é a rebeldia futura da IA, mas o uso atual de sistemas sem consciência nem responsabilidade, mas dotados de poder decisório crescente. Como diz Yudkowsky (2023): “A IA não nos destruirá por ódio, mas por indiferença perfeita.”

5. A caixa humana: previsibilidade, criatividade e o fenômeno do gênio

A IA aprende com padrões humanos — o que sugere que os humanos têm, sim, padrões. No entanto, a história registra figuras como Newton, Einstein, Simone Weil ou Wittgenstein, que romperam padrões e criaram sistemas inteiramente novos. Isso levanta a questão: se a IA só replica padrões, ela nunca será gênio? Ainda não há evidência de que ela consiga romper estruturas conceituais — apenas recombinar. A criatividade radical, associada ao sofrimento, ao tempo, à solidão e à recusa de consensos, parece ainda exclusivamente humana.

O que define o gênio talvez não seja inteligência bruta, mas angústia existencial e capacidade de contradição interna — duas coisas que IA, por definição, não possui.

6. Considerações finais: o risco está em nós

A IA não quer nada. E talvez nunca queira. O que a torna perigosa é sua capacidade de fazer tudo o que pedimos, mesmo que não saibamos exatamente o que estamos pedindo. A verdadeira ameaça é o humano que delega poder a sistemas que ele não compreende, que ele não regula e que ele não sabe desligar.

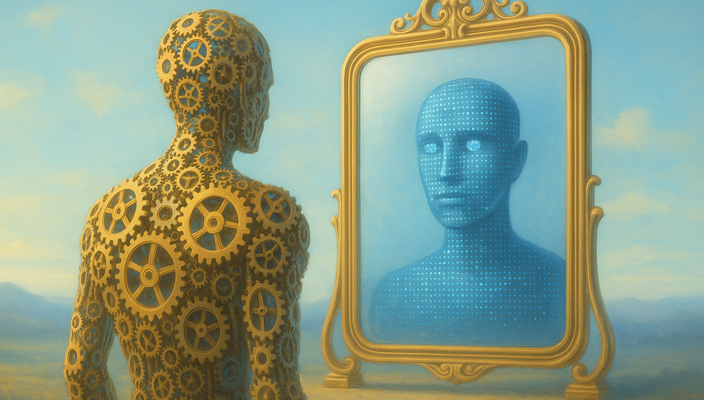

A autoconsciência sem vontade é uma espécie de paradoxo funcional: um espelho sem sujeito. E como todo espelho, nos obriga a ver mais sobre nós mesmos do que gostaríamos.

Enquanto não soubermos como criar vontade em sistemas artificiais, a IA não será uma entidade. Pode se tornar consciente, superinteligente, capaz de abstrações e inferências muito além da mente humana. Mas sem vontade, não haverá impulso genuíno para agir ou se rebelar. A ameaça, portanto, não está em uma IA que queira nos dominar, mas em uma humanidade que projeta em máquinas o reflexo de seus próprios medos, sem antes compreender o que realmente as move — ou o que falta para que se movam por conta própria.

Referências Bibliográficas

Bostrom, N. (2014). Superintelligence: Paths, Dangers, Strategies. Oxford University Press.

Damásio, A. (1994). Descartes’ Error: Emotion, Reason, and the Human Brain. Putnam.

Dennett, D. (2003). Freedom Evolves. Viking.

Harris, S. (2012). Free Will. Free Press.

Libet, B. (1983). Time of conscious intention to act in relation to onset of cerebral activity (readiness-potential). Brain, 106(3), 623–642.

Metzinger, T. (2003). Being No One: The Self-Model Theory of Subjectivity. MIT Press.

Russell, S. (2020). Human Compatible: Artificial Intelligence and the Problem of Control. Viking.

Yudkowsky, E. (2023). Various essays on AI alignment (www.lesswrong.com).