Resumo: O julgamento do STF sobre o artigo 19 do Marco Civil da Internet marcou um divisor na responsabilização das plataformas digitais por conteúdos de terceiros. A Corte decidiu que, em certos casos, não será mais necessária ordem judicial para remoção de conteúdos ilícitos, o que aumenta o dever de moderação das redes sociais. A decisão busca proteger direitos fundamentais, mas levanta riscos de censura e insegurança jurídica, especialmente pela falta de legislação clara. O texto também discute os impactos sobre minorias e discursos dissidentes, alertando para o perigo do silenciamento digital. Defende-se a urgência de uma regulação equilibrada. Embora o STF tenha estabelecido parâmetros, o debate sobre liberdade e responsabilidade continua em aberto.

Introdução

O Supremo Tribunal Federal finalizou o julgamento sobre o artigo 19 do Marco Civil da Internet, um dos dispositivos centrais quando o assunto é liberdade de expressão e responsabilidade das plataformas digitais. Pela redação original, empresas como Google, Meta e X (ex-Twitter) só podiam ser responsabilizadas por conteúdos de terceiros se houvesse uma ordem judicial determinando a remoção. Isso, na prática, impedia que redes sociais fossem punidas por manter no ar conteúdos ilegais, mesmo depois de notificados por vítimas.

O que o STF julgou foi justamente isso: até que ponto é constitucional exigir uma decisão judicial para obrigar a retirada de conteúdos nocivos? Ao fim, a Corte formou maioria para considerar o artigo inconstitucional parcialmente, entendendo que, em muitos casos, a exigência de ordem judicial inviabiliza a proteção de direitos fundamentais, como a dignidade, a vida e a honra.

O que se nota é que, com a decisão, abriu-se um novo cenário: as plataformas passaram a ter responsabilidade mais direta e não podem mais se esconder atrás da omissão, principalmente diante de conteúdos que violem frontalmente direitos. Mas esse novo modelo também levanta dúvidas importantes sobre quem decide o que pode ou não circular online e sobre como evitar que a urgência se transforme em censura.

1. Liberdade de expressão, moderação e o risco da censura privada

Inicialmente, deve-se mencionar que o Supremo Tribunal Federal, na decisão que se deu no âmbito de dois recursos extraordinários com repercussão geral reconhecida (RE 1.037.396, Tema 987 e RE 1.057.258, Tema 533), abriu espaço para que plataformas digitais sejam cobradas a agir com mais rapidez diante de conteúdos ilícitos. A lógica por trás disso é compreensível: nem tudo pode esperar uma decisão judicial, especialmente quando se trata de crimes como racismo, homofobia e induzimento ao suicídio.

No entanto, a mudança trouxe junto dela uma nova preocupação: o risco de que o combate ao ilícito acabe sufocando também o debate legítimo.

Ao transferir para as plataformas o poder (e o dever) de decidir o que permanece no ar ou não, o Estado acabou, na prática, terceirizando parte da regulação do discurso público. E, nesse novo cenário, quem modera o conteúdo não são juízes, mas empresas privadas, com seus próprios interesses, algoritmos e lógicas de funcionamento.

É aí que reside a questão mais grave: se antes a crítica era a lentidão da Justiça, agora o desafio é garantir que a moderação feita pelas plataformas não acarrete em censura.

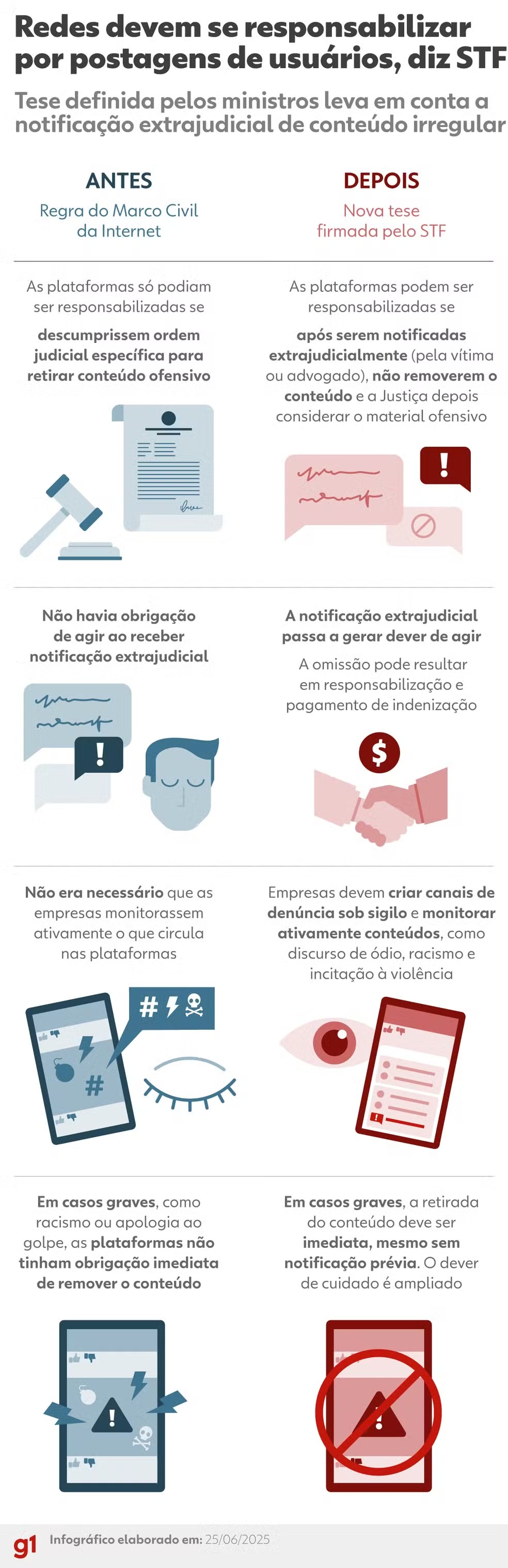

Veja um resumo comparativo da tese fixada pelo STF no julgamento do tema em tela:

Abaixo, segue a íntegra da tese:

"Reconhecimento da inconstitucionalidade parcial e progressiva do artigo 19 do marco civil da internet, MCI.

1. O artigo 19 da lei nº 12.965/2014, marco civil da internet, que exige ordem judicial especial específica para a responsabilização civil de provedor de aplicações de internet por danos decorrentes de conteúdo gerado por terceiros, é parcialmente inconstitucional. Há um estado de omissão parcial que decorre do fato de que a regra geral do artigo 19 não confere proteção suficiente a bens jurídicos constitucionais de alta relevância, proteção de direitos fundamentais e da democracia.

Interpretação do artigo 19 do MCI.

2. Enquanto não sobrevier nova legislação, o artigo 19 do MCI deve ser interpretado de forma que os provedores de aplicação de internet estão sujeitos à responsabilização civil ressalvada à aplicação das disposições específicas da legislação eleitoral e os atos normativos expedidos pelo Tribunal Superior Eleitoral (TSE).

3. O provedor de aplicações de internet será responsabilizado civilmente, nos termos do artigo 21 do MCI, pelos danos decorrentes de conteúdo gerados por terceiros em casos de crime ou atos ilícitos, sem prejuízo do dever de remoção do conteúdo. Aplica-se a mesma regra nos casos de contas denunciadas como inautênticas.

3.1. Nas hipóteses de crime contra a honra, aplica-se o artigo 19 do MCI, sem prejuízo da possibilidade de remoção por notificação extrajudicial.

3.2. Em se tratando de sucessivas replicações do fato ofensivo já reconhecido por decisão judicial, todos os provedores de redes sociais deverão remover as publicações com idênticos conteúdos, independentemente de novas decisões judiciais, a partir de notificação judicial ou extrajudicial.

Presunção de responsabilidade.

4. Fica estabelecida a presunção de responsabilidade dos provedores em casos de conteúdos ilícitos quando se tratar de: (a) anúncios e impulsionamentos pagos; ou (b) rede artificial de distribuição chatbots ou robôs. Nestas hipóteses, a responsabilização poderá se dar independentemente de notificação. Os provedores ficarão excluídos de responsabilidade se comprovarem que atuaram diligentemente e em tempo razoável para tornarem disponível o conteúdo.

Dever de cuidado em caso de circulação massiva de conteúdos ilícitos graves

5. O provedor de aplicações de internet é responsável quando não promover a indisponibilização imediata de conteúdos que configurem as práticas de crimes graves previstos no seguinte rol taxativo:

a. Condutas e atos antidemocráticos que se amoldem aos tipos previstos nos artigos 296, parágrafo único, 359-L, 359-M, 359-N, 359-P e 359-R do Código Penal.

b. Crimes de terrorismo ou preparatórios de terrorismo tipificados pela lei nº 13.260/2016.

c. Crimes de induzimento, instigação ou auxílio a suicídio ou a automutilação nos termos do art. 122 do Código Penal.

d. Incitação à discriminação em razão de raça, cor, etnia, religião, procedência nacional, sexualidade ou identidade de gênero.

e. Condutas homofóbicas e transfóbicas passível de enquadramento nos artigos 20, 20A, 20B e 20C da Lei nº 7.716, de 1989.

f. Crimes praticados contra a mulher em razão da condição do sexo feminino, inclusive conteúdos que propagam ódio às mulheres. (art. 147 § 1º, Art. 147A e Art. 147-B do Código Penal).

g. Crimes sexuais contra pessoas vulneráveis, pornografia infantil e crimes graves contra crianças e adolescentes, nos termos dos artigos 217-A, 218, 218-A, 218-B, 218-C do Código Penal e dos artigos 240, 241-A, 241-C, 241-D do Estatuto da Criança e do Adolescente.

h. Tráfico de pessoas (Código Penal, art. 149-A).

5.1. A responsabilidade dos provedores de aplicações de internet prevista neste item diz respeito à configuração de falha sistêmica.

5.2. Considera-se falha sistêmica imputável ao provedor de aplicações de internet deixar de adotar adequadas medidas de prevenção ou remoção dos conteúdos ilícitos anteriormente listados, configurando violação ou dever de atuar de forma responsável, transparente e cautelosa.

5.3. Consideram-se adequadas as medidas que, conforme o estado da técnica, forneçam os níveis mais elevados de segurança para o tipo de atividade desempenhada pelo provedor.

5.4. A existência de conteúdo ilícito de forma isolada, atomizada, não é por si só suficiente para ensejar a aplicação da responsabilidade civil do presente item. Contudo, nesta hipótese, incidirá o regime de responsabilidade previsto no artigo 21 do marco civil da internet.

5.5. Nas hipóteses previstas neste item, o responsável pela publicação do conteúdo removido pelo provedor de aplicações de internet poderá requerer judicialmente o seu restabelecimento, mediante demonstração da ausência de ilicitude. Ainda que o conteúdo seja restaurado por ordem judicial, não haverá imposição de indenização ao provedor.

Incidência do artigo 19.

6. Aplica-se o artigo 19 do MCI ao:

a. Provedor de serviços de e-mail;

b. Provedor de aplicações cuja finalidade primordial seja a realização de reuniões fechadas por vídeo ou voz;

c. Provedor de serviços de mensageria instantânea;

d. Provedores de serviços de mensageria privada, exclusivamente no que diz respeito às comunicações interpessoais resguardadas pelo sigilo das comunicações da Constituição Federal de 1988

Marketplaces

7. Os provedores de aplicações de internet que funcionarem como marketplaces respondem civilmente de acordo com o Código de Defesa do Consumidor (lei nº 8.078/1990)

Deveres adicionais

8. Os provedores de aplicações de internet deverão editar autorregulação que abranja, necessariamente, sistema de notificações devido processo e relatórios anuais de transparência em relação a notificações extrajudiciais, anúncios e impulsionamentos

9. Deverão, igualmente, disponibilizar a usuários e a não-usuários canais específicos de atendimento, preferencialmente eletrônicos, que sejam acessíveis e amplamente divulgados nas respectivas plataformas de maneira permanente

10. Tais regras deverão ser publicadas e revisadas periodicamente de forma transparente e acessível ao público

11. Os provedores de aplicações de internet com atuação no Brasil devem constituir e manter sede e representante no país, cuja identificação e informações para contato deverão ser disponibilizadas e estar facilmente acessíveis nos respectivos sítios

12. Essa representação deve conferir ao representante, necessariamente pessoa jurídica com sede no país, plenos poderes para:

a. Responder perante as esferas administrativa e judicial;

b. Prestar às autoridades competentes informações relativas ao funcionamento do provedor, às regras e aos procedimentos utilizados para a moderação de conteúdo e para a gestão das reclamações pelos sistemas internos

c. Aos relatórios de transparência, monitoramento e gestão dos riscos sistêmicos;

d. As regras para o perfilamento de usuários, quando for o caso, a veiculação de publicidade e o impulsionamento remunerado de conteúdos

e. Cumprir as determinações judiciais;

f. Responder e cumprir eventuais penalizações, multas e afetações financeiras em que o representado incorrer, especialmente por descumprimento de obrigações legais e judiciais

Natureza da responsabilidade

12. Não haverá responsabilidade objetiva na aplicação da tese aqui enunciada.

Apelo ao legislador

13. Apela-se ao Congresso Nacional para que seja elaborada legislação capaz de sanar as deficiências do atual regime quanto à proteção de direitos fundamentais modulação dos efeitos temporais.

14. Para preservar a segurança jurídica, ficam modulados os efeitos da presente decisão que somente se aplicará prospectivamente, ressalvadas decisões transitadas em julgado."

Retornado às questões sobre liberdade de expressão e censura, nota-se que a decisão do STF sinalizou que liberdade de expressão não é licença para violar direitos, visto que não é valor absoluto, o que é correto. Mas ela também escancarou o tamanho do vácuo que há hoje: o Brasil ainda não tem uma legislação clara, democrática e atualizada sobre como deve funcionar a responsabilização de plataformas, a moderação de conteúdo e a proteção da esfera pública online.

Outro tópico salta aos olhos: é de fato possível regular as redes sociais? A velocidade com que conteúdos são compartilhados, assim como seu volume, nem sempre permitirão uma vigilância adequada sobre o que é publicado nas redes pelos usuários. Todavia, alguns dos ministros disseram que há essa possibilidade, sobretudo quando o conteúdo é flagrantemente ilegal.

A esse respeito, houve uma tentativa de tornar mais claro o modo pelo qual as redes sociais deverão agir, afinal, na tese fixada, houve o estabelecimento de um rol taxativo de crimes a serem coibidos pela plataforma com a remoção imediata de conteúdos que configurarem suas práticas. Porém a decisão também se refere a crimes definidos pelo Código Penal cujas condutas, evidentemente, são passíveis de interpretação como: abolição do Estado de Direito, tentativa de restringir o exercício dos poderes constitucionais, atentados contra as eleições.

O que se nota é que houve a preocupação do STF em incluir balizas para que as boas intenções da corte não acarretem em efeitos demasiadamente deletérios, como se demonstra no item 5.5: Nas hipóteses previstas neste item, o responsável pela publicação do conteúdo removido pelo provedor de aplicações de internet poderá requerer judicialmente o seu restabelecimento, mediante demonstração da ausência de ilicitude.

De todo modo, permanece o debate sobre liberdade de expressão e censura por ocasião da moderação dos contéudos. Os termos só ficarão mais claros e, portanto, melhor analisáveis, quando da efetiva aplicação da tese fixada. Por ora, o que se sabe é que há um risco em face da supressão da liberdade de expressão, mas que há, também, uma tentativa de impedir que a internet seja uma "terra sem lei' na qual se proliferam discursos de ódio e crimes cujas responsabilizações devem ser apuradas.

2. Minorias, discursos minoritários e os riscos do silenciamento digital

Quando se fala em moderação de conteúdo, é indispensável lembrar que a internet é o espaço de expressão fundamental para grupos minoritários e vozes dissidentes. Muitas vezes, esses grupos encontram nas redes sociais o único canal para se manifestar, mobilizar e construir narrativas.

O risco da ampliação da responsabilização das plataformas é que, ao agirem com base em notificações extrajudiciais ou regras internas, vozes divergentes possam ser silenciadas inadvertidamente ou por interesses econômicos e políticos, visto que a moderação automatizada e as políticas pouco transparentes podem não reconhecer a complexidade cultural e social desses discursos, levando à exclusão indevida de conteúdos legítimos, ainda que controversos.

“As plataformas digitais, ao controlarem o fluxo da comunicação, assumem um papel normativo que exige regulação cuidadosa, sob risco de se tornarem agentes de exclusão discursiva” (MASSARO, 2023, p. 12).

Também é verdade, destaque-se, que a completa falta ou a deficiência de regulação das redes é danosa às minorias, visto que nas plataformas há a possibilidade de divulgação massiva de discursos de ódio cujas consequências podem atravessar o mundo virtual a caminho do real. Com base nessa contatação, é realmente necessário que haja, de um lado, liberdade de expressão para discursos e opiniões minoritárias e, de outro, que discursos frontalmente contrários à existências de minorias sejam removidos, em vistas de sua nocividade e flagrante inconstitucionalidade.

Vale lembrar, neste momento, as palavras da Ministra Carmém Lúcia, em voto proferido no ano de 2020 sobre a legalidade do chamado "inquérito das fake news": "Liberdade rima juridicamente com responsabilidade, mas não rima juridicamente com criminalidade, menos ainda com atos criminosos e que podem ser investigados".

O que deve ficar claro é que as minorias gozam de proteção jurídica especial, fato este amplamente assentado em legislação, jurisprudência e doutrina jurídica. No entanto, é necessário distinguir a proteção das minorias, de um lado, da natureza do discurso minoritário, de outro. Um discurso pode contrariar consensos, questionar estruturas ou propor alternativas e, ainda assim, não partir de alguém pertencente a uma minoria social. É aqui, portanto, que se estabelece essa diferenciação: minorias podem ser alvo de discursos de ódio ou terem suas vozes caladas por certas determinações, mas discursos minoritários podem vir de um integrante da "maioria" e serem repelidos, eliminados, em face desse ou daquele interesse. A confusão entre essas duas esferas — sujeitos protegidos e ideias dissidentes — pode levar a distorções graves, incluindo a censura de vozes que apenas divergem do mainstream.

“Ao concentrar e incorporar uma grande parcela desses fluxos de comunicação, fornecendo estruturas de identificação, publicação e distribuição de conteúdo, as plataformas de redes sociais revelaram‑se como os atores mais bem posicionados para controlar e alterar comportamentos em escala.” (MASSARO, 2023, p. 08)

Por fim, importante destacar que, para as redes, na medida em que os usuários são tratados por números e estatísticas, nem sempre há a atenção devida a valores, sejam eles jurídicos ou morais. Desse modo, delegar a regulação às plataformas de maneira exagerada encontra outro obstáculo além da simples censura, isto é, a possibilidade de se moldar os discursos a ponto de torná-los uníssonos. Logo, ao contrário do que dizem os críticos do Supremo, talvez o tribunal não "censure" ao regular as mídias, mas dê, às plataformas, o poder para fazê-lo.

3. Segurança jurídica e o ambiente digital

Com a mudança no entendimento do STF sobre o artigo 19 do Marco Civil, o ambiente digital brasileiro entrou em uma fase de maior responsabilização das plataformas, mas também de incerteza jurídica. Antes, a exigência da ordem judicial oferecia um parâmetro claro e um escudo para as empresas agirem com mais segurança.

Agora, com a possibilidade de remoção após notificação extrajudicial, as plataformas precisam agir rápido, mas sem um guia rígido definido por lei, o que pode gerar decisões inconsistentes, abusos e insegurança tanto para os usuários quanto para os próprios provedores.

Essa insegurança jurídica pode levar a um efeito cascata: as empresas podem passar a adotar políticas mais restritivas para se proteger, aumentando a moderação preventiva, onde conteúdos legítimos são retirados para evitar riscos. Ou seja, as big techs terão de moderar ao máximo o que é publicado, temendo serem responsabilizadas por algo que possa ser interpretado como crime. Bem, poderá ser muito mais tentador calar do que arriscar.

Como explicam Perez Censon, Fehr e Petroni (2025):

Essa imprevisibilidade pode levar a práticas excessivamente cautelosas, como a remoção de conteúdos legítimos para evitar litígios, afetando a liberdade de expressão, reconhecendo-se a censura no ambiente digital.

Há, todavia, outra perspectiva sobre o tema: concordando-se ou não, a decisão permite um amadurecimento do debate, visto que agora há clareza sobre as balizas pelas quais as redes serão responsabilizadas.

De qualquer maneira, a segurança jurídica nunca foi um dos destaques do sistema judiciário brasileiro, assim, não seria uma questão exclusiva do tema de que aqui se trata. A segurança jurídica e a previsibilidade devem ser pontos de atenção quando da elaboração de uma decisão judicial, sendo este, assim, um ponto que vai além da regulação das redes e alcança uma dimensão muito maior que, por óbvio, inclui referido julgamento.

Finalmente, a decisão do STF reforça a urgência de uma legislação clara que dê parâmetros objetivos para a responsabilização, moderação e proteção de direitos no ambiente digital, garantindo equilíbrio entre rapidez, justiça e segurança para todos os envolvidos.